[리뷰] 누워서 읽는 통계학

in Review on Review, Book, 통계학, 통계, 데이터, 확률, 추정, 분포, 검정, 상관분석, 회귀분석, 베이즈

한빛아카데미출판사의"누워서 읽는 통계학(와쿠이 요시유키, 와쿠이 사다미 저/권기태 역)"를 읽고 작성한 리뷰입니다.

기술 및 추론 통계와 확률을 시작으로 상관, 회귀, 베이즈 분석까지 다루고 있는 통계학 입문서이다. 특히, 강제로 외우고 넘어가거나 대충 알고 넘어갔던 개념들을 빠짐 없이 설명해 나간다는 점이 가장 돋보이는 장점이다.

처음엔 한빛 출판의 “누워서 읽는” 시리즈에 좋은 인상이 있어 이 책의 제목에 막연히 끌렸는데 책을 다 읽고나니 제목에 본 키워드를 포함할만한 자격이 있는 책이라 생각했다.

비록 통계학 전공자는 아니지만 AI 분야를 공부하며 시간이 허락하는대로 통계학도 열심히 공부중인데 그간 대충 그렇다하여 개념만 정리하고 넘어갔던 지식들이나 다들 그렇다고 하니 강제로 외웠던 지식들을 기초 수준에서 꼼꼼하게 재구성할 수 있어 만족스러웠다.

예를 들면 본 도서에서 소개한 베이즈 추론의 이유 불충분의 원칙, 우도함수 등의 개념이 그러한데 이는 어느 도서에서도 쉽게 설명하는 책을 거의 본 적이 없다.

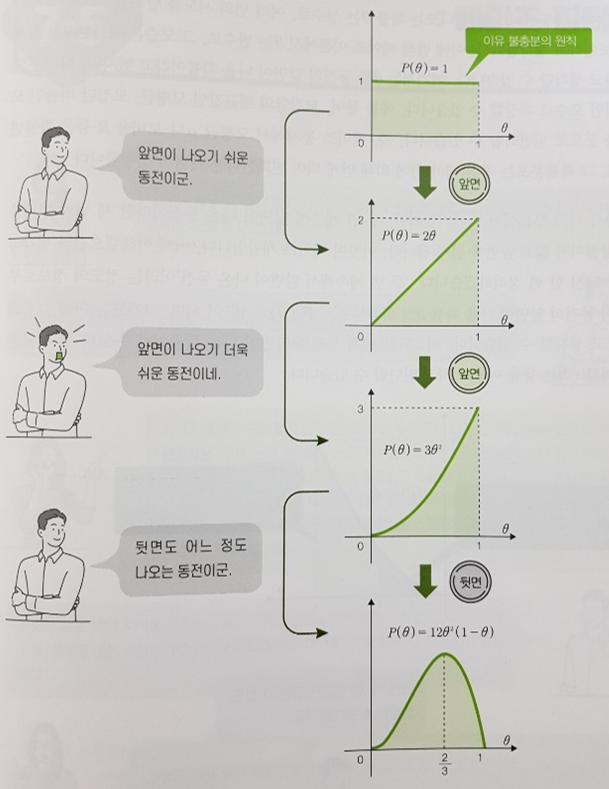

확률 문제 중 가장 쉬운 예제가 동전 던지기가 아닐까 싶다. 베이즈 추론같이 수학적으로 엄격하게 표현하기 까다로운 개념을 이해시키기 위해 저자는 동전 던지기라는 쉬운 예제를 선택한다. 덕분에 베이즈 추론과 상관없는 개념들을 이해하느라 집중력을 흐뜨리지 않을 수 있고 자신감을 얻고 개념을 익힐 수 있다.

아래 그림은 이유 불충분의 원칙을 설명하는 그림인데 동전을 던질때마다 앞, 앞, 뒷면이 나옴에 따라 앞면이 나올 확률인 쎄타의 확률분포가 어떻게 변하는지 보여주는 직관적인 그림이다. 이렇게 쉽게 이해할 수 있는 것을 몇년 전 다른책에서 복잡한 예제에 대입해보며 억지로 머리 속에 쑤셔넣느라 고생했던 기억이 있다.

본 도서처럼 쉽게 설명할 수 있는 것을 왜 다른 책에서는 필요한 것들은 빙빙돌려 설명하고 불필요한 것들은 집중적으로 설명하며 입문자들을 힘들게 했는지 모르겠다.

더불어 이제는 알고 있는 개념이지만 입문 시절 은근히 어려웠던 개념들도 다시 새로운 시각으로 바라볼 수 있어 좋았다. 결정계수의 의미라든지, 귀무가설과 유의확률, 불편성과 자유도 등의 개념을 예로 들 수 있겠는데 이는 입문 시절에는 쉽게 와 닿지 않는 개념이다.

책에서 다루는 내용이 꽤 방대하여 모든 것을 짚어보긴 어려워 대표적으로 위에서 예시를 든 개념들을 본 도서에서는 어떻게 다루는지 하나씩 소개해보려 한다.

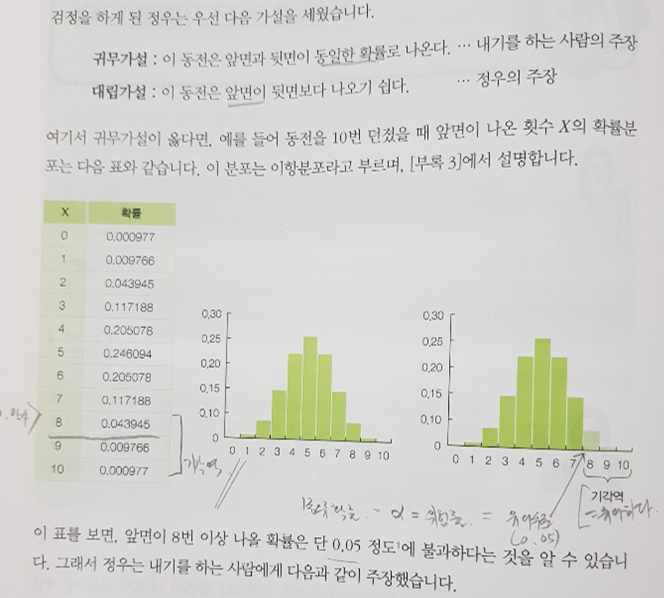

우선 검정 파트의 꽃이라 할 수 있는 귀무가설과 유의확률에 대한 설명이다. 이 역시 동전던지기 예제로 귀무가설을 설명하고 있어 통계 검정의 핵심에만 집중할 수 있도록 도와준다.

검정이 처음 배우기에 어려운 가장 큰 이유는 사실 귀무가설이나 대립가설을 어떤 것으로 정해야 할지 혼동되기 때문일 것이다. 위 그림은 귀무가설을 동전 앞뒷면 확률이 동일한 것으로 명확히 정하고 있어 다른 케이스에 적용하기 용이하다.

또 검정의 절차는 기계식으로 적용하면 된다고 설명하여 입문자에게 혼선을 주지 않으며 동전던지기 예제로 한 단계씩 예를 들며 검정을 수행하고 있어 추후 독자가 수행하고 싶은 검정 또한 동일한 방식으로 따라하면 쉽게 검정 단계를 거칠 수 있을 것이다.

더불어 검정 대상의 확률이 귀무가설이 주장하는 값보다 크거나 적음에 따라 우측, 좌측 검정을 시행하는데 이 또한 처음 접하면 헷갈리기 쉬운 개념인데 이런 부분들을 놓치지 않고 하나씩 설명해 나감은 물론 애매모호한 용어는 어떤 것이 동일어인지 비교해주는 면도 마음에 들었다. 예를 들면 1종 오류값이나 a값, 위험률, 유의수준이 같은 개념임을 잘 설명하고 있다.

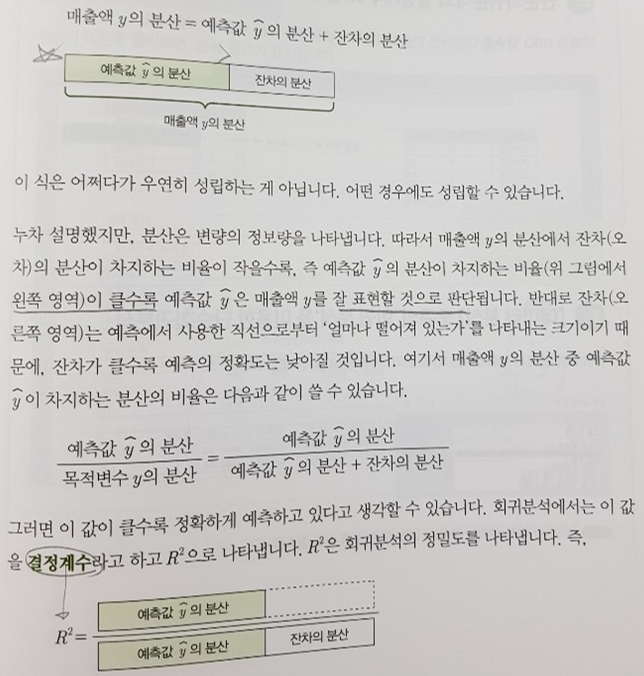

이어서 아래 그림을 보면 결정계수가 가지는 의미를 직관적으로 파악할 수 있다. 전체 분산은 예측값의 분산과 잔차의 분산으로 구성되는데 이 중 예측값의 분산이 전체 비중의 높은 값을 차지할 수록 예측의 정확도가 높다는 개념을 아래 한 페이지의 설명으로도 대부분 이해할 수 있다.

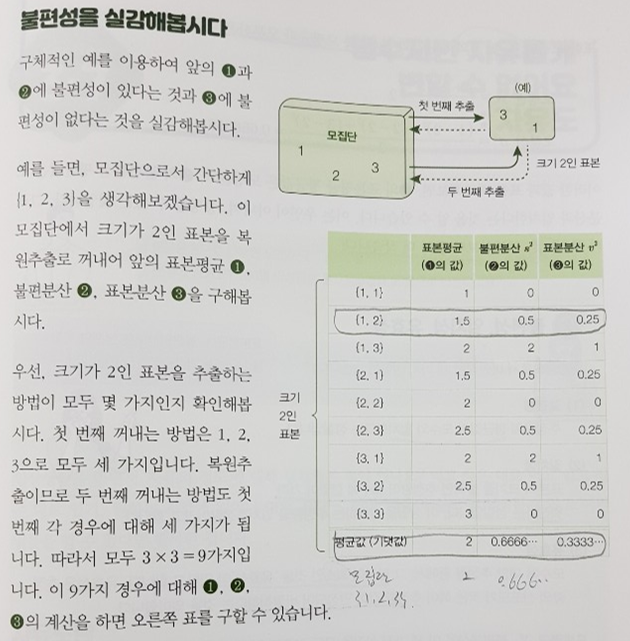

자유도에 -1이 필요한 이유 또한 불편성의 개념 설명으로 잘 전달하고 있다. 모집단 {1,2,3}에서 크기가 2인 표본을 추출하는 방법은 총 9가지 인데 각 경우에 따라 표본평균, 불편분산, 표본분산을 직접 계산해 보면 왜 불편 추정량을 써야 모집단을 예측하기에 정확한 것인지 또 그러한 불편성에 의해 자유도가 왜 고려되어야 하는지 명확하게 눈으로 확인해볼 수 있다.

그 외에도 통계보다 딥러닝을 먼저 다룬 이들이 처음에 항상 궁금해하는 정규화와 표준화의 차이나 확률 분포, 또는 확률변수의 관점에서 새롭게 유도한 공식을 통한 기대값 공식의 도출 원리 등을 살피다 보면 AI에 필수적인 기초 개념을 확실하게 잡아갈 수 있다.

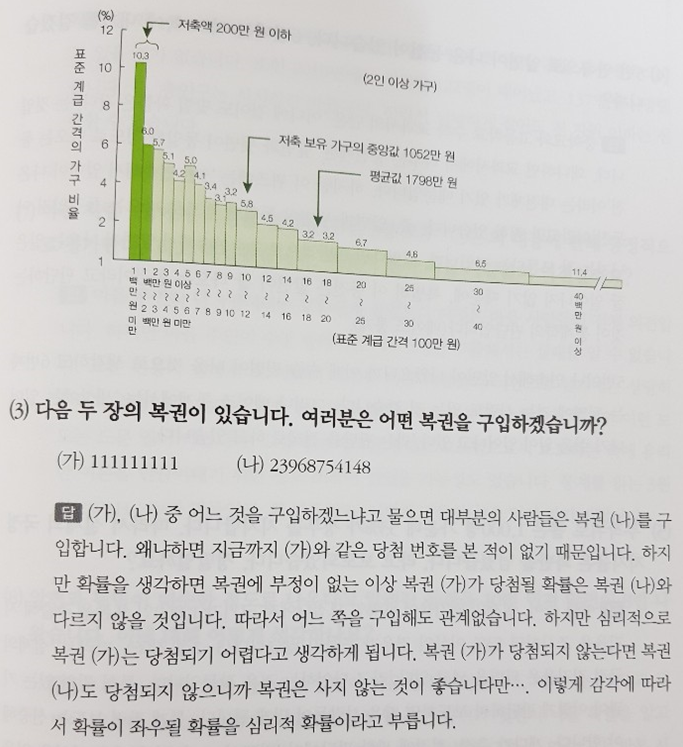

책에 흥미를 돋구고 실용적인 일상에 도움될만한 예제 퀴즈가 자주 등장하는 점도 책의 장점이다.

위 그림의 두 장의 복권 중 어떤 번호를 선택할지 고르는 흥미로운 문제는 단순해 보이지만 확률의 기본 개념부터 베이지안 진영에 이르기까지 통계의 역사적 발전과정을 엿볼 수 있는 예제이다. 또 추정, 검정 파트에 등장하는 다양한 실용적인 예제들은 실제 분석에 도움을 줄만한 대표적인 케이스들이다.

통계학 전공 혹은 비전공자 중에도 데이터 분석 혹은 AI에 입문하고픈 이라면 이 책으로 시작하는 것이 상당히 유리한 고지를 선점하는 것이라 평하고 싶다. 특정 개념에 집중하기 위해서는 그 핵심에만 집중할 수 있도록 다른 가지들을 심플하게 만드는 것이 중요한데 이 책이 그러한 기본을 매우 충실하게 따르고 있기 때문이다.

리뷰를 마치며 통계에 어려움을 느끼는 이들, 통계 전공에 입문하는 이들, 더불어 구체적인 예제와 숫자로 원리가 어떻게 움직이는지 밑바닥을 들여다보고 싶은 이들에게 강력히 추천하고 싶은 교과서보다 훌륭한 입문서라 평하고 싶다.